type

status

date

summary

slug

tags

category

password

icon

本文以在CDH安装过组件后需要重新安装的情况为场景,以Kafka为例。

其实在CDH安装组件的时候出错,大多数原因都是由于之前安装或者使用过组件,删除时只时在CM上删除了,但实际上组件的文件仍在节点机器上存在,再次在CM上傻瓜式安装就会出错。

一、安装 Kafka

在CDH安装Kafka 比较简单,按照安装流程一路点下去就好了。

- Broker数量按照实际情况配置即可

- 概念来自与Apache ActiveMQ,指MQ的服务端,帮你把消息从发送端传送到接收端。 简单点说,一台节点上部署了Kafka,那就是一个Broker

- MirrorMaker按照实际情况配置即可,一般没特殊需求不需要配置

- MirrorMaker连接器是一个基于消费者和生产者的连接器,它可以将一个Kafka集群中的所有主题和分区复制到另一个Kafka集群中。MirrorMaker连接器支持多种复制策略,包括简单复制、批量复制和延迟复制等。用户可以根据自己的需求选择不同的复制策略来实现不同的数据镜像效果。MirrorMaker连接器还支持多种转换器,可以让用户在复制数据时进行数据格式转换和数据过滤等操作。

- Gateway是CDH的说法,可以去CDH官方文档了解,一般不配置

- 网关是一种特殊类型的角色,其唯一目的是指定一个主机,当该主机上没有运行任何角色时,该主机应接收特定服务的客户端配置。网关角色使Cloudera Manager能够在该主机上安装和管理客户端配置。没有与网关角色关联的进程,其状态将始终处于停止状态。 您可以为HBase、HDFS、Hive、Kafka、MapReduce、Solr、Spark、sqoop1客户端和YARN配置网关角色。

二、无法安装 Kafka

以下以Kafka为例,其实在CDH安装组件的时候出错,大多数原因都是由于之前安装或者使用过组件,删除时只时在CM上删除了,但实际上组件的文件仍在节点机器上存在,再次在CM上傻瓜式安装就会出错。

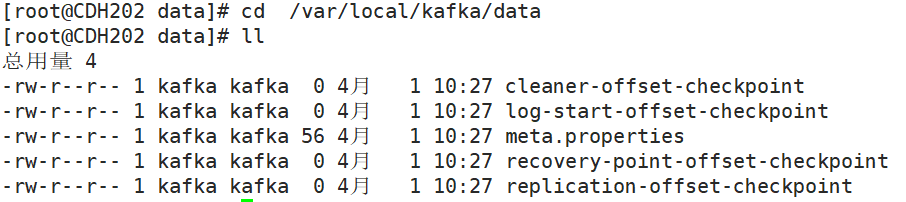

1. 删除 Kafka 产生的data

重新安装Kafka,留存中重新分配的Kafka一直安装不成功,是因为在CDH停用Kafka时不会删除已经有节点数据。

所以需要注意删除

/var/local/kafka/data

下的数据文件,可以看这个路径下的文件:

注意:

如果搭建的分布式,则各个结点的这个路径中的数据都需要删除,不然会导致只有删除 /var/local/kafka/data 数据的结点可以启动Kafka,其他均会启动失败。

2. 删除 Kafka 在 ZK 中产生的主题数据

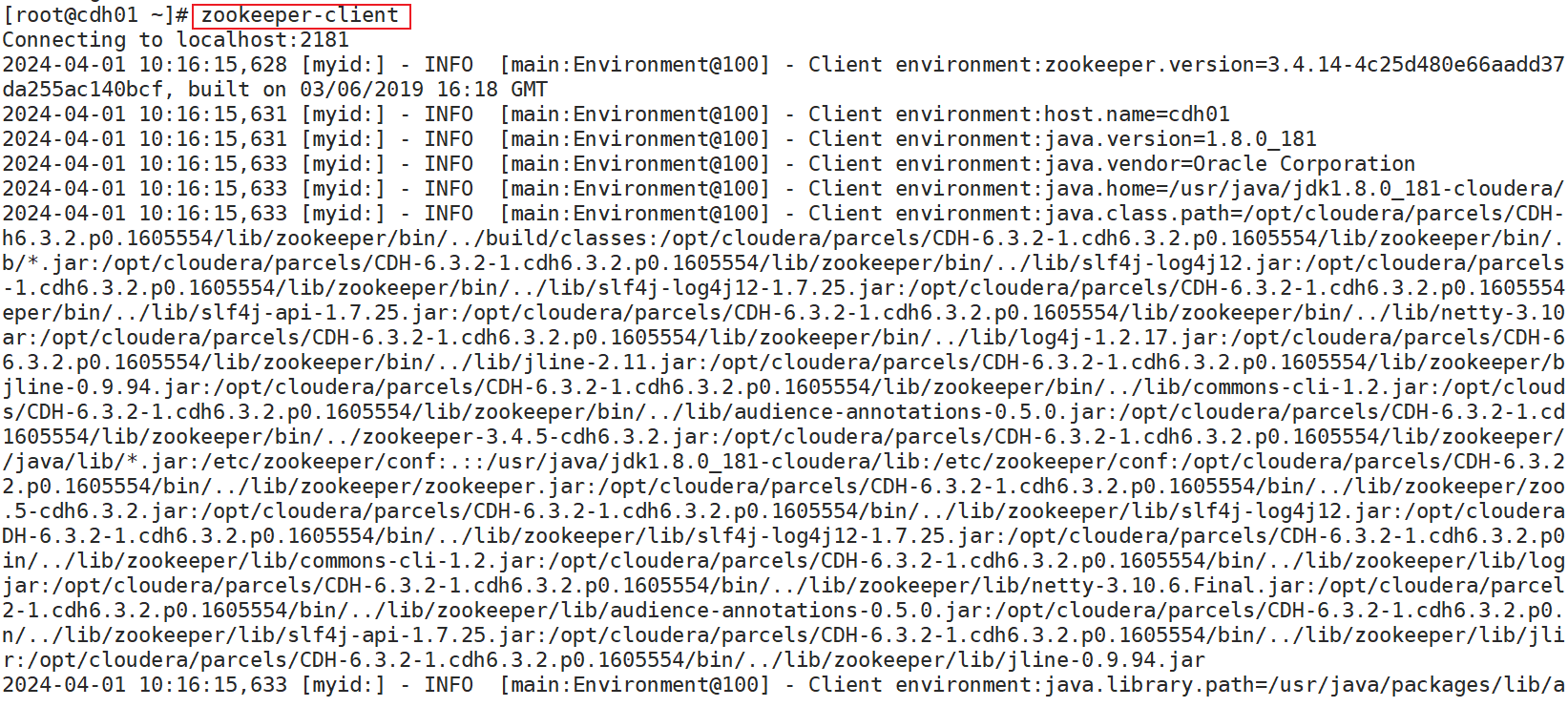

首先先连接 Zookeeper:

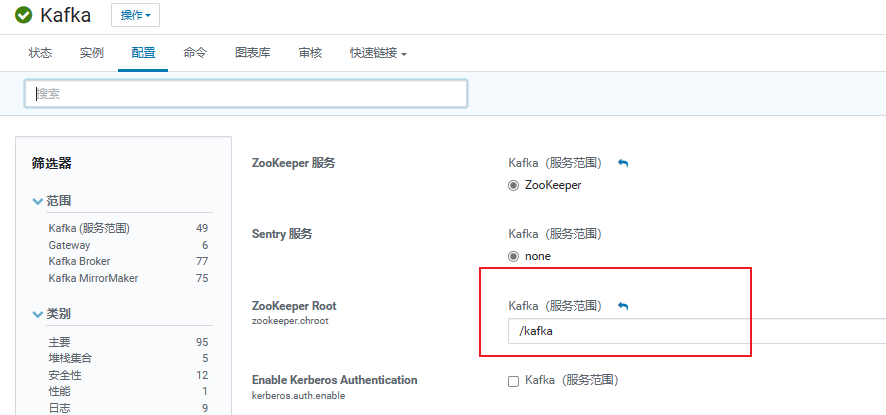

CDH中安装配置Kafka时填写过 ZooKeeper Root 配置

一般也就是 “/” 与下图的 “/kafka” 两种路径(默认没管的是 “/” )

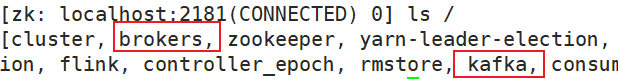

所以需要对应删除掉 zookeeper 中的 “/brokers/topic” 或者 “/kafka/brokers/topics” 的主题数据

- 删除掉 zookeeper 中的 “/brokers/topic” 的主题数据

- 删除掉 zookeeper 中的 “/kafka/brokers/topics\” 的主题数据(若存在)

这样之前安装的Kafka基本清理干净了,可以再试着重新安装。

- 作者:PH3C

- 链接:https://notion.966699.xyz//article/cdh-kafka

- 声明:本文采用 CC BY-NC-SA 4.0 许可协议,转载请注明出处。

相关文章